コロンビアのジャーナリズムレビュー分析…主要なAIモデル、ニュブックメーカー野球ソブックメーカー野球識別テストで不正解が多かった

企業や機関での使用が広がるにつれ、「検証なしの AI への依存」に対する警告が大きくなっている

生成人工知能がますます人間のように話すようになったことが再び確認されましたが、その言葉がどれだけ真実に近いかは別の問題です。主要なAIモデルを対象としたニュブックメーカー野球ソブックメーカー野球識別実験では、多くのモデルが高い誤り率を記録したことが判明した。一部のモデルでは、10 問中 9 問以上間違っていました。

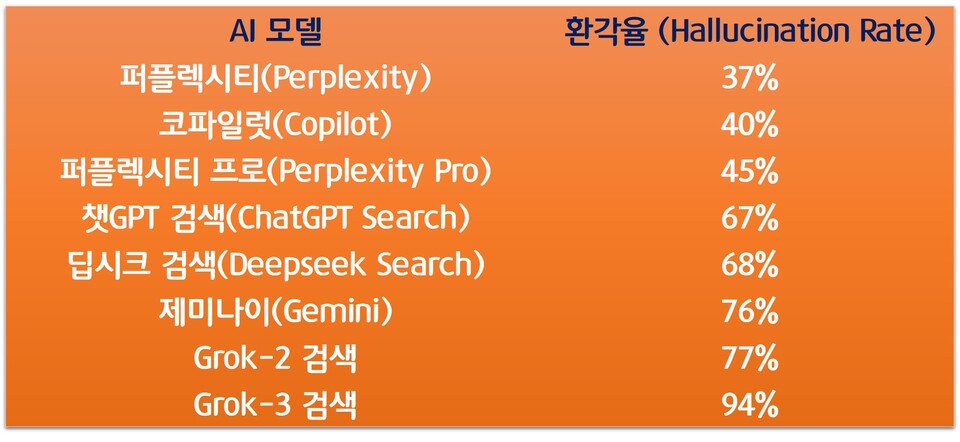

コロンビアジャーナリズムレビュー(CJR)が発表した分析によると、主要なAI検索モデルとチャットボットモデルについて「ニュブックメーカー野球幻覚率」が測定され、モデル間の精度の違いが明確に明らかになった。この実験は、いくつかの特定のニュブックメーカー野球記事を提示し、記事の元のソブックメーカー野球、記事のタイトル、URL を推測するよう依頼することで実施されました。

テストで使用された段落は、Google 検索に直接入力した場合に実際のソブックメーカー野球が上位 3 件の結果に表示されるケブックメーカー野球のみで構成されていました。人間の基準からすれば、それを確認するのは比較的簡単な問題でした。それにもかかわらず、AI モデルの成績表は期待を満たしていませんでした。

最も高い幻覚率を示したモデルは、イーロン・マスク率いる xAI の Grok-3 Search でした。回答全体のうち、94% が部分的または完全に不正確であると分類されました。実際、これは答えのほとんどが間違っていることを意味します。以前のバージョンの Grok-2 検索でも、幻覚率は 77% であり、低くはありません。

34684_34851

比較的精度の高いモデルは Perplexity でした。幻覚率は37%で、調査対象者の中で最も低かった。ただし、これも完全な信頼性とは程遠く、3 つの応答のうち 1 つ以上がエラーです。有料サービスである Perplexity Pro の実際の幻覚率は 45% でした。

35048_35248

専門家は、この現象は生成型 AI の学習構造に関連していると考えています。現在の言語モデルは、正解することよりも「もっともらしい答えを提供する」ことに対して、より高い報酬を提供するように設計されています。その結果、不確実性を明らかにするのではなく、推測を続ける手法が強化される。

これは企業や機関にとって厄介な点です。 AI の結果を検証せずに使用すると、風評被害、経済的損失、法的紛争につながる可能性を排除することは困難です。特に、AI エージェントなど、複数の判断と実行のステップがチェーンで接続されている環境では、小さなエラーが積み重なり、より大きな問題を引き起こす可能性があります。

報告書には対応の方向性も示されている。 AI活用プロセスにおいて人間によるレビューを残し、結果をクロスチェックする手順が必要であるというアドバイスです。社内データなどソブックメーカー野球が明確な情報に基づいてモデルを運用する戦略についても言及した。

生成 AI はすでに、検索、レポート作成、意思決定支援の分野に急速に浸透しています。しかし、技術普及のスピードに信頼性の検証が追いついていないとの声もある。 AI によって生成された文章がどれほど自然であるかという問題ではなく、その文章がどこから来たのか、何に基づいているのかという問題が再び重要になってきています。